BERT模型(1)

BERT(全称Bidirectional Encoder Representation from Transformers)是由Google开发的一种预训练语言模型,它在自然语言处理任务中取得了很大的成功。BERT通过将文本输入模型中,使用Transformer编码器从左到右和从右到左进行训练,从而实现了双向的上下文理解能力。这使得BERT能够更好地理解上下文中的词语和句子之间的关系,从而在各种自然语言处理任务中取得了领先水平的性能,如文本分类、命名实体识别、语义角色标注等。

可以说BERT的出现是NLP领域里具有里程碑意义的大事件。

NLP任务的BERT模式

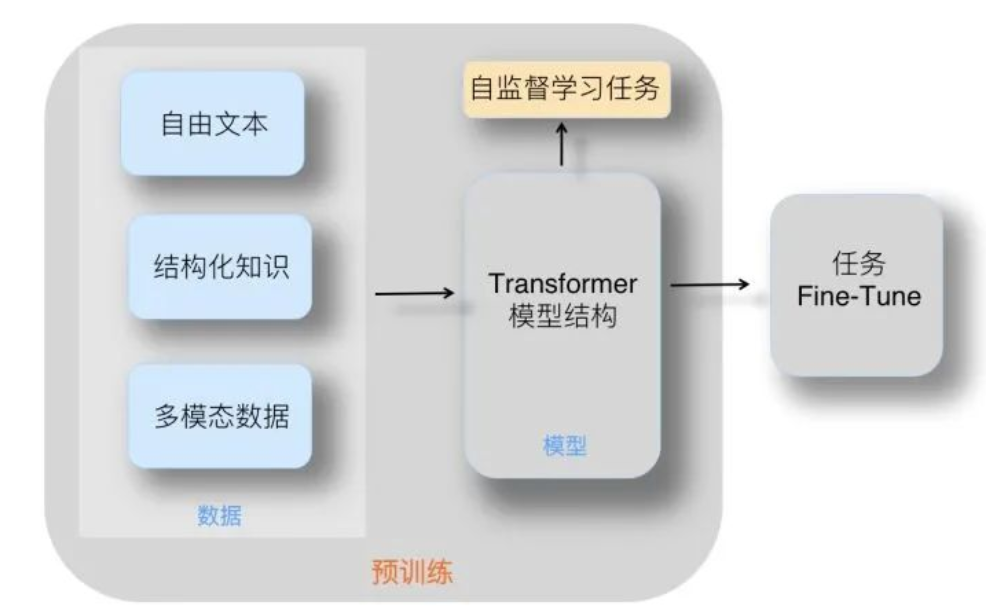

在BERT框架下,解决NLP问题会划分为序列进行的两个阶段:第一阶段是预训练阶段,然后是Fine-tuning阶段。

预训练通过学习大量的语料获得语言学知识,微调则真正让我们的模型解决实际生活中问题。