视觉神经网络的演化(1)-- 早期探索

LeNet可以说是CNN的开端,麻雀虽小,但五脏俱全,卷积层、池化层、全连接层,这些都是现代CNN网络的基本组件。而AlexNet是另一个具有历史意义的网络结构,它的成功表示了深度学习重回历史舞台。

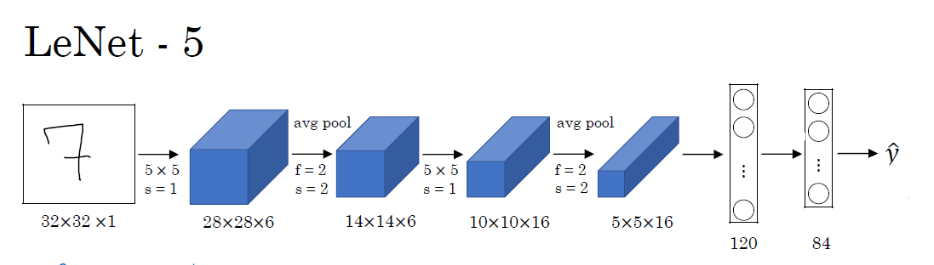

LeNet-5

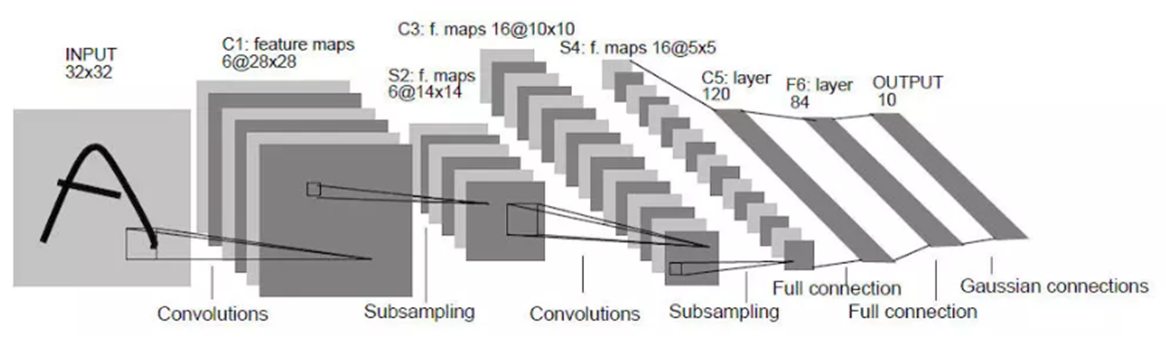

下图是广为流传LeNet的网络结构,随着网络越来越深,图像的宽度和高度都在缩小,信道数量一直在增加。目前,一个或多个卷积层后边跟一个池化层,再接上一个全连接层的排列方式很常用。

1 | import torch |

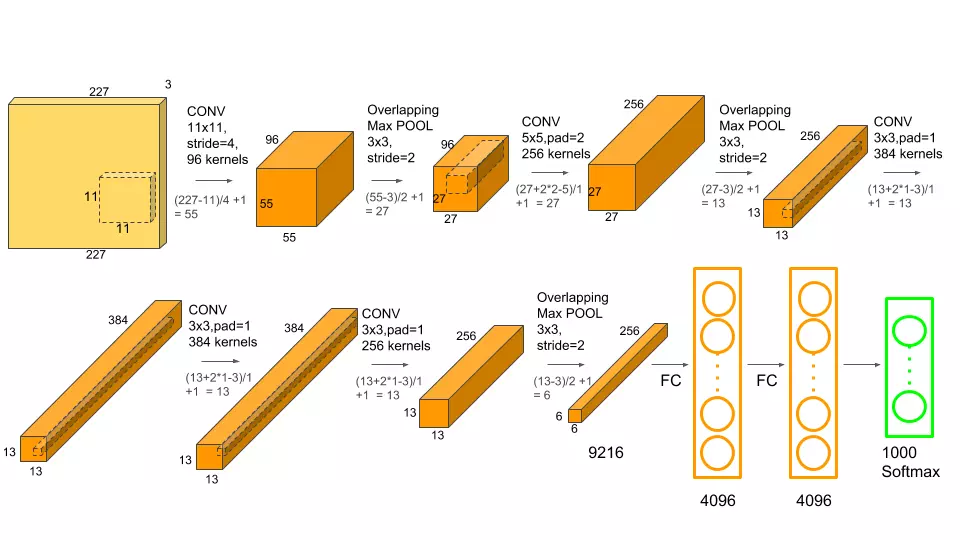

AlexNet

AlexNet 可以说是具有历史意义的一个网络结构,可以说在AlexNet之前,深度学习已经沉寂了很久。历史的转折在2012年到来,AlexNet 在当年的ImageNet图像分类竞赛中,top-5错误率比上一年的冠军下降了十个百分点,而且远远超过当年的第二名。

AlexNet的诞生开启了深度学习的时代,虽然后来大量比AlexNet更快速更准确的卷积神经网络结构相继出现,但是AlexNet作为开创者依旧有着很多值得学习参考的地方,之后在Imagenet上取得更好结果的ZF-net,VGG等网络,都是在其基础上修改得到。

该网络包括:卷积层 5个,池化层 3个,全连接层:3个(其中包含输出层) 。

创新

(1)采用了ReLU激活函数,而不像早期卷积神经网络所采用的Tanh或Sigmoid激活函数

(2)用多层小卷积代替单个大卷积层。

(3)提出了LRN层(局部响应归一化层),增强模型泛化能力。

(4)每个全连接层后面加上Dropout层减少了模型的过拟合问题。

(5)使用了数据增强。

1 | import torch |